W erze, gdy dostęp do zaawansowanych modeli językowych kojarzy się głównie z chmurą i płatnymi subskrypcjami, LM Studio oferuje rewolucyjne podejście: sztuczną inteligencję działającą lokalnie na Twoim komputerze, bez konieczności kodowania i skomplikowanej konfiguracji.

W tym artykule pokażemy, jak w kilka minut stworzyć własne AI, wykorzystując to narzędzie, oraz przeanalizujemy jego kluczowe funkcje i ograniczenia.

Czym jest LM Studio?

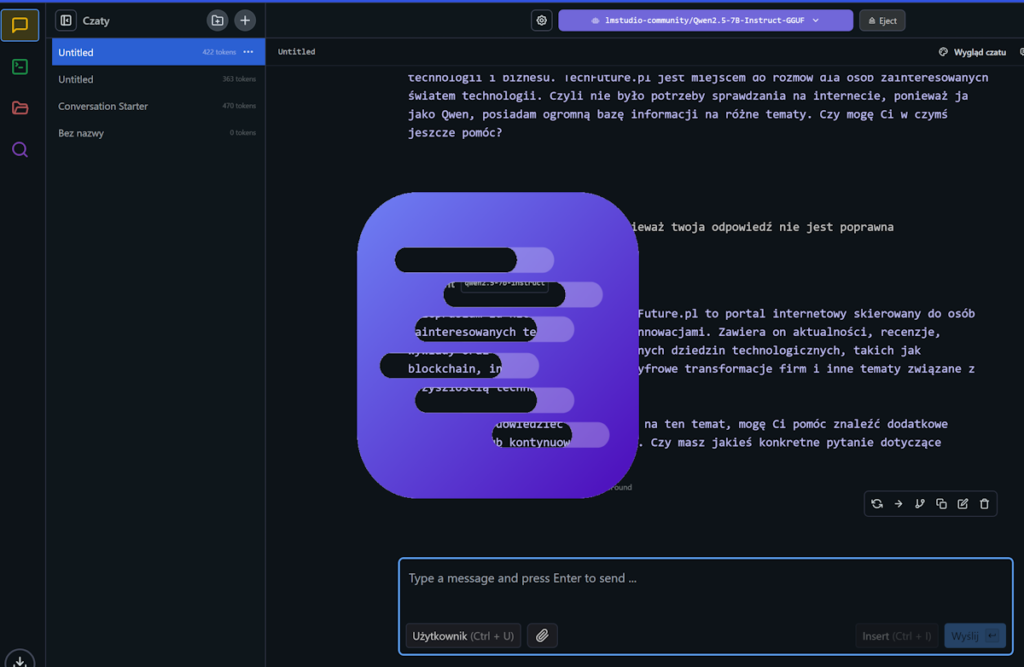

LM Studio to desktopowa aplikacja umożliwiająca lokalne uruchamianie otwartych modeli językowych (LLM) takich jak Llama 3, Mistral czy Qwen. Działa na systemach Windows, macOS i Linux, a jej główną zaletą jest prosty interfejs graficzny oraz pełna niezależność od internetu.

Kluczowe funkcje

- Offline AI: Wszystkie obliczenia odbywają się na Twoim urządzeniu, co gwarantuje ochronę danych i brak opóźnień.

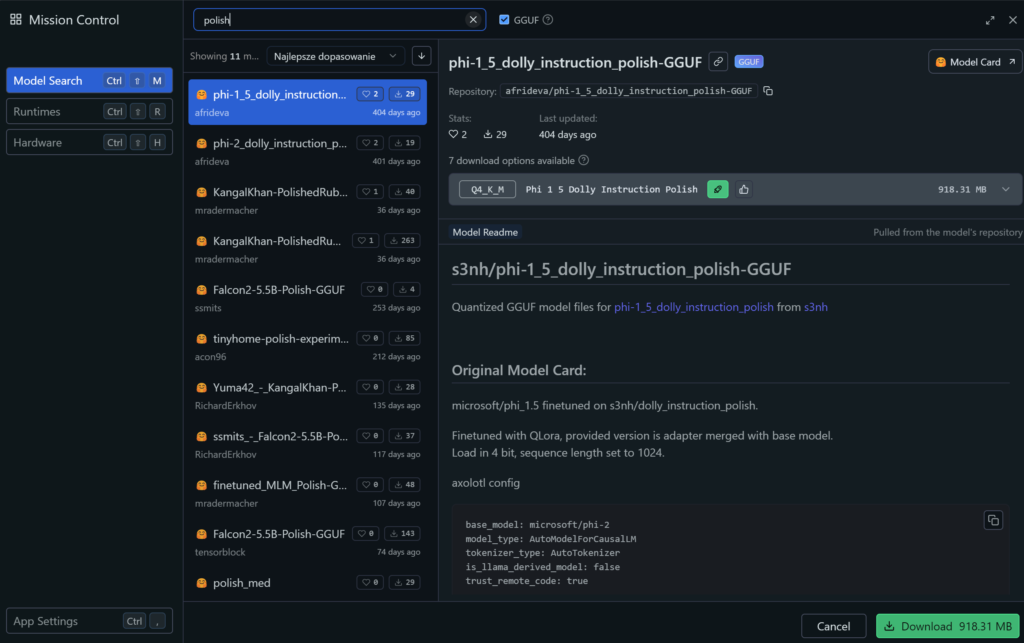

- Integracja z Hugging Face: Możliwość pobierania ponad 150 modeli GGUF bezpośrednio z platformy, w tym specjalistycznych wersji dla koderów (np. Qwen2.5 Coder).

- Chat z dokumentami: Wersja 0.3 wprowadziła funkcję RAG (Retrieval-Augmented Generation), pozwalającą analizować lokalne pliki PDF, DOCX czy TXT.

- Serwer API: Udostępnianie modelu przez interfejs kompatybilny z OpenAI, co umożliwia integrację z narzędziami jak Obsidian czy Visual Studio Code.

Jak zacząć? Instalacja w 3 krokach

Krok 1: Pobierz i zainstaluj LM Studio

- Wejdź na oficjalną stronę i wybierz wersję dla swojego systemu.

- Wymagania sprzętowe:

- Minimalne: 16 GB RAM, 10 GB wolnego miejsca na dysku

- Optymalne: NVIDIA GPU z CUDA (dla przyspieszenia obliczeń) lub Apple M1/M2 z obsługą MLX.

Krok 2: Wybierz i pobierz model

W zakładce Discover znajdziesz modele posegregowane według parametrów (np. 7B, 13B) i zastosowań. Dla początkujących poleca się:

- Mistral 7B: Uniwersalny model o dobrym stosunku wydajności do zużycia zasobów.

- Llava-Phi-3-Mini: Wersja z obsługą wprowadzania wizualnego (zdjęcia, schematy).

Krok 3: Rozpocznij rozmowę z AI

Po załadowaniu modelu w sekcji Chat możesz:

- Zadawać pytania w 90+ językach

- Generować kod (np. „Napisz funkcję Pythona obliczającą silnię”)

- Analizować załączone dokumenty (np. „Podsumuj główne tezy z załączonego raportu”).

Case study: LM Studio w akcji

Przykład 1: Personalny asystent kodowania

Integracja z Visual Studio Code poprzez rozszerzenie Continue.dev pozwala na:

- Autouzupełnianie kodu w czasie rzeczywistym

- Debugowanie z pomocą AI (np. „Znajdź błąd w tej funkcji JavaScript”).

// Przykładowa konfiguracja VS Code

{

"tabAutocompleteModel": {

"apiBase": "http://localhost:1234/v1/",

"model": "qwen2.5-coder:14b"

}

}

Przykład 2: Analiza poufnych dokumentów

Firma prawnicza wykorzystuje LM Studio do przeszukiwania lokalnych akt sądowych bez ryzyka wycieku danych. Dzięki funkcji Local Document Chat, AI odpowiada na zapytania typu: „W którym paragrafie umowy jest mowa o karach za opóźnienia?”.

Zalety i wyzwania

✅ Zalety

- Prywatność: Zero przesyłania danych do chmury – idealne dla lekarzy, prawników, finansistów.

- Niski koszt: Brak opłat za tokeny (w przeciwieństwie do OpenAI API).

- Elastyczność: Możliwość testowania niszowych modeli (np. specjalistycznych w medycynie).

❌ Wyzwania

- Wymagania sprzętowe: Modele 70B+ wymagają nawet 64 GB RAM i GPU z 24 GB VRAM.

- Brak fine-tuningu: LM Studio nie pozwala na trenowanie własnych modeli, tylko wykorzystuje gotowe.

LM Studio vs konkurencja

| Funkcja | LM Studio | Ollama | GPT-4 All-in-One |

|---|---|---|---|

| Obsługa GPU | ✅ (CUDA/Metal) | ✅ | ❌ |

| Interfejs graficzny | ✅ | ❌ (CLI) | ✅ |

| Integracja z VS Code | ✅ | ✅ (przez API) | ❌ |

| Cena | Darmowa | Darmowa | Od $20/miesięcznie |

Tabela 1: Porównanie narzędzi do lokalnego uruchamiania LLM.

Przyszłość LM Studio

Wersja 0.3.8 wprowadziła kluczowe usprawnienia jak obsługę notacji matematycznej LaTeX i optymalizację dla Apple M4. Na 2025 rok zapowiedziano:

- Wsparcie dla modeli multimodalnych (tekst+obraz+wideo)

- Pluginy społecznościowe (np. integracja z Google Drive)

- Tryb headless do przemysłowego wykorzystania AI.

Podsumowanie: Dla kogo jest LM Studio?

To narzędzie idealnie sprawdzi się dla:

- Developerów chcących integrować AI z aplikacjami bez kosztów chmury

- Firm wrażliwych na bezpieczeństwo danych

- Entuzjastów AI eksperymentujących z różnymi modelami

Jeśli szukasz alternatywy dla ChatGPT działającej offline, LM Studio jest najprostszym wyborem. Pamiętaj jednak, że wydajność zależy od Twojego sprzętu – na słabszych komputerach lepiej sprawdzą się modele 7B-13B.

Jeden komentarz

Na 16 GB ram i 6 GB vram, to i 20b chodzi choć wolno